یادگیری ماشین

در انگلستان ویکتوریا Ada دوست و همدست چارلز Babbage، مخترع موتور تحلیلی بود: اولین هدف عمومی شناختهشده، کامپیوتر مکانیکی. اگر چه بلندپرواز و بسیار جلوتر از زمان خودش، به عنوان یک کامپیوتر هدف عمومی در دهه ۱۸۳۰ و ۱۸۴۰ طراحی شدهبود، زیرا مفهوم محاسبات با هدف کلی هنوز اختراع نشده بود. صرفاً به این معنا بود که راهی برای استفاده از عملیات مکانیکی برای خودکار کردن محاسبات خاص در حوزه آنالیز ریاضی بود که از این رو، موتور تحلیلی نام گرفت.

در سال ۱۸۴۳، Ada Lovelace در مورد اختراع اظهار داشت: " موتور تحلیلی ادعای هیچ چیزی را ندارد. این کار میتواند هر کاری که ما میدانیم را انجام دهد … این ابزار برای کمک به ما در فراهم کردن آنچه که قبلاً با آن آشنا هستیم، کمک میکند."

این اظهارات بعدها توسط آلن تورینگ از پیشگامان هوش مصنوعی ، به عنوان "اعتراض به Lady Lovelace" در کتاب نقطه عطف "ماشینآلات و اطلاعات"، نقل شد که آزمون تورینگ و همچنین مفاهیم کلیدی را معرفی کرد که برای شکل دادن به هوش مصنوعی به کار خواهند رفت. Turing در حالی که فکر میکرد که آیا کامپیوترهای شخصی قادر به یادگیری و اصالت هستند یا نه، و او به این نتیجه رسید که آنها میتوانند.

یادگیری ماشینی از این سوال ناشی میشود: آیا یک کامپیوتر میتواند فراتر از آنچه ما میدانیم استفاده کنیم و نحوه انجام یک کار مشخص را یاد بگیریم؟ آیا کامپیوتری میتواند ما را غافلگیر کند؟ به جای برنامه نویسان که قواعد پردازش داده را با دست انجام میدهند، یک کامپیوتر به طور خودکار این قوانین را با نگاه کردن به دادهها یاد میگیرد؟

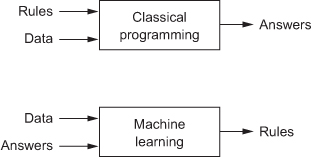

این سوال در را به یک پارادایم برنامهنویسی جدید باز میکند. در برنامهنویسی سنتی، پارادایم نمادین هوش مصنوعی، قوانین ورودی انسان (یک برنامه) و دادهها مطابق با این قواعد پردازش میشوند و پاسخ میآیند (شکل ۱.۲ را ببینید). با یادگیری ماشین، دادههای ورودی انسان و همچنین پاسخهای مورد انتظار از دادهها و خارج شدن از قانون. سپس این قواعد میتوانند برای دادههای جدید بکار گرفته شوند تا پاسخهای اصلی تولید شوند.

شکل ۱.۲. یادگیری ماشین: یک نمونه برنامهنویسی جدید

سیستم یادگیری ماشین به جای برنامهریزی صریح، آموزش داده میشود. آن با مثالهای فراوانی مرتبط با یک کار ارائه میشود، و ساختار اماری در این مثالها پیدا میکند که در نهایت به سیستم اجازه میدهد تا با قواعد خودکار کردن تکلیف به کار خود ادامه دهد. به عنوان مثال، اگر میخواهید وظیفه برچسب زدن عکسهای تعطیلات خود را خودکار کنید، میتوانید یک سیستم یادگیری ماشین با مثالهای زیادی از تصاویر که قبلاً توسط انسانها علامتگذاری شدهاند را ارایه کنید، و این سیستم قوانین آماری را برای تداعی عکسهای خاص به برچسبهای خاص یاد خواهد گرفت.

اگرچه یادگیری ماشین تنها در دهه ۱۹۹۰ شروع به شکوفایی کرد، اما به سرعت تبدیل به محبوبترین و موفقترین گروه هوش مصنوعی شد، روندی که از دسترس بودن سختافزار سریعتر و مجموعه دادههای بزرگتر ناشی میشود. یادگیری ماشین به شدت مربوط به آمار ریاضی است، اما از چندین روش مهم متفاوت است. برخلاف آمار، یادگیری ماشینی تمایل دارد با مجموعه دادههای پیچیده و پیچیده (مانند مجموعه دادهها از میلیون پیکسل) سروکار داشته باشد، که هر کدام متشکل از دهها هزار پیکسل هستند که تحلیل آماری کلاسیک مانند آنالیز بیزی غیرعملی است. در نتیجه، یادگیری ماشین، و به خصوص یادگیری عمیق، نظریه نسبتاً کمی ریاضی دارد - شاید خیلی کم - و مهندسی محور است. این یک نظم و انضباط است که در آن ایدهها به طور تجربی بیشتر از لحاظ نظری ثابت میشوند.